- Email: info@datamanagement.es

- Tel: 637 99 11 94

Descarga e importación de datos de ejemplo

Introducción

Para poder practicar las consultas y los modelos de DBT, necesitamos contar con datos de ejemplo en nuestra base de datos PostgreSQL.

Utilizaremos el conjunto de datos Chinook, una base de datos de muestra que contiene información de una tienda de música digital: artistas, álbumes, canciones, clientes, facturas, etc.

Es un dataset muy útil para aprender porque incluye tablas relacionadas y datos realistas.

Descarga del fichero SQL

El script SQL de carga está disponible en el siguiente enlace:

- Abrir el enlace.

- Hacer clic en Raw para ver el archivo en formato plano.

- Guardar el fichero en el PC con el nombre:

- Chinook_PostgreSql_AutoIncrementPKs.sql

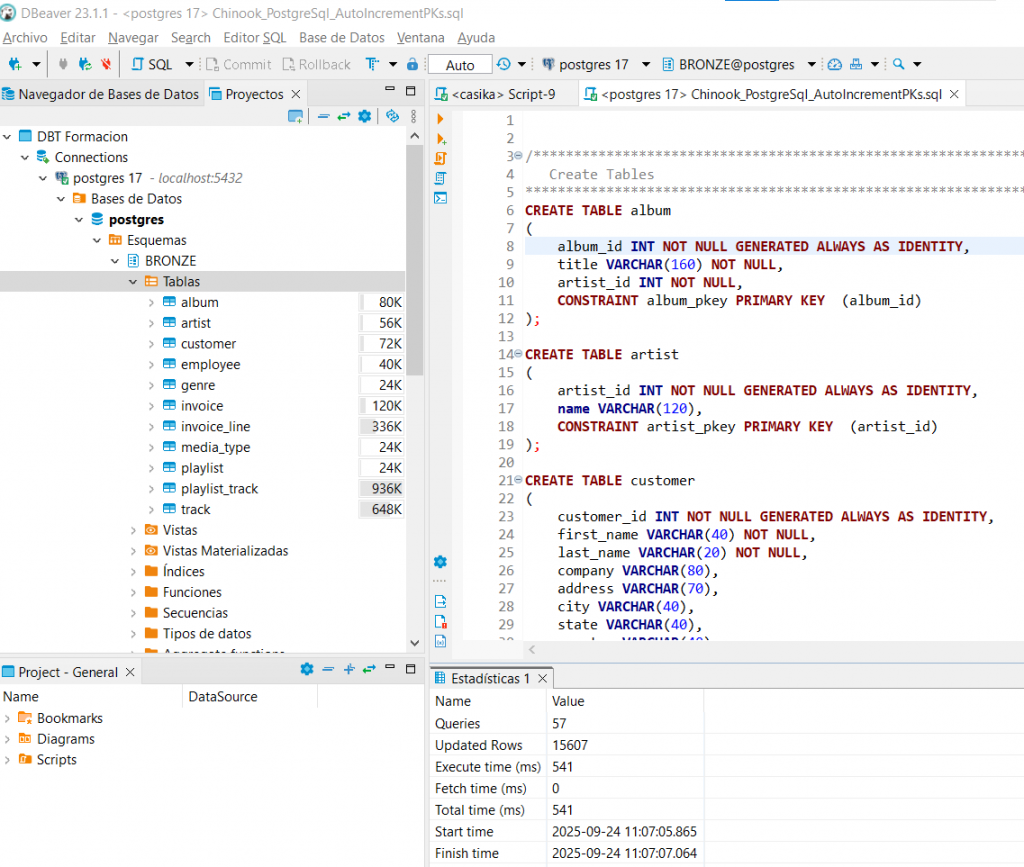

Importación en PostgreSQL desde DBeaver:

- Abrir la conexión a PostgreSQL.

- Menú SQL Editor > Open SQL Script.

- Seleccionar el fichero .sql y ejecutarlo.

Extracción y Carga (Extract and Load)

Introducción

El primer paso en cualquier proceso de integración de datos es la extracción y la carga (Extract and Load).

Extracción (Extract): consiste en obtener los datos desde la fuente original, que puede ser una base de datos transaccional, un fichero CSV, un servicio en la nube o una API.

Carga (Load): consiste en mover esos datos hacia un sistema de destino, como un Data Warehouse o un Data Lake, donde después podrán analizarse o transformarse.

Nuestro caso práctico

En un paso previo ya hemos descargado y ejecutado el script SQL que carga el dataset Chinook en nuestra base de datos PostgreSQL.

De este modo, ya disponemos de todas las tablas y datos necesarios para comenzar a trabajar en los siguientes módulos de la formación.

Lo que hemos hecho manualmente con un script representa un ejemplo simplificado de lo que, en un entorno profesional, se implementaría mediante pipelines automatizados.

Entorno profesional (visión general)

En proyectos reales, estas tareas suelen estar a cargo de ingenieros de datos o programadores backend, que construyen pipelines para mover datos desde las fuentes hasta los sistemas de almacenamiento o análisis.

Los destinos más comunes incluyen:

- Data Lakes: almacenamiento masivo y flexible (ej. AWS S3, Azure Data Lake Storage, Google Cloud Storage).

- Bases de datos relacionales: PostgreSQL, MySQL, SQL Server.

- Data Warehouses en la nube: BigQuery (GCP), Redshift (AWS), Synapse (Azure).

- Procesamiento en tiempo real: mediante colas y sistemas de streaming como Kafka o Pub/Sub.

Leave a Comment

Lo siento, debes estar conectado para publicar un comentario.

Virgen del pilar nº4, ático H

03330 Crevillente (Alicante)

Francisco Rodriguez Alfaro